Наджиб Й. Маджай

Център за невронни науки, Нюйоркски университет, Ню Йорк, Ню Йорк, САЩ

Денис Г. Пели

Департамент по психология и Център за невронни науки, Нюйоркски университет, Ню Йорк, Ню Йорк, САЩ

Резюме

Много изследвания на науката за зрението използват машинно обучение, особено версията, наречена „дълбоко обучение“. Невролозите използват машинно обучение за декодиране на невронни реакции. Учените по възприятията се опитват да разберат как живите организми разпознават обектите. За тях дълбоките невронни мрежи предлагат референтна точност за разпознаване на научени стимули. Първоначално машинното обучение е вдъхновено от мозъка. Днес машинното обучение се използва като статистически инструмент за декодиране на мозъчната дейност. Утре дълбоките невронни мрежи може да се превърнат в най-добрия ни модел на мозъчна функция. Този кратък преглед на използването на машинното обучение в биологичното зрение засяга неговите силни, слаби страни, етапи, противоречия и настоящи насоки. Тук се надяваме да помогнем на учените по зрение да преценят каква роля трябва да играе машинното обучение в техните изследвания.

Въведение

Какво предлага машинното обучение на учените по биологично виждане? Той е разработен като инструмент за автоматизирана класификация, оптимизиран за точност. Машинното обучение се използва в широк спектър от приложения (Brynjolfsson, 2018), от регресия в прогнозирането на фондовия пазар до засилване на обучението за игра на шах, но тук се фокусираме върху класификацията. Физиолозите го използват, за да идентифицират стимули въз основа на нервната активност. За да изследват възприятието, физиолозите измерват нервната активност, а психофизиците измерват явни отговори, като натискане на бутон. Физиолозите и психофизиците започват да разглеждат дълбокото обучение като модел за разпознаване на обекти от човешки и нечовешки примати (Cadieu et al., 2014; Khaligh-Razavi & Kriegeskorte, 2014; Yamins et al., 2014; Ziskind, Hénaff, LeCun, & Пели, 2014; Тестолин, Стоянов и Зорзи, 2017). Предполагаме, че повечето от нашите читатели са чували за машинно обучение, но се чудят дали това би било полезно в техните собствени изследвания. Започваме с описанието на някои от плюсовете и минусите му.

Плюсове: За какво е полезно

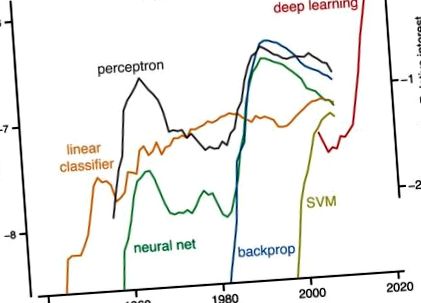

Най-малкото машинното обучение е мощен инструмент за интерпретиране на биологични данни. Особена форма на машинно обучение, дълбокото обучение, е много популярна (Фигура 1). Това е просто мода? За компютърното зрение старата парадигма беше: откриване на характеристики, последвано от сегментиране и след това групиране (Marr, 1982). С инструментите за машинно обучение новата парадигма е просто да дефинира задачата и да предостави набор от етикетирани примери, а алгоритъмът изгражда класификатора. (Това е „контролирано“ обучение; по-долу обсъждаме ученето без надзор.)

История на популярността. Мащаб отляво: Честотата на поява на всеки от петте термина - линеен класификатор, перцептрон, поддържаща векторна машина, невронна мрежа и backprop, (и не задълбочено обучение) - в книги, индексирани от Google през всяка година на публикуване. Google преброява случаи на думи и фрази от n думи и нарича всеки „ngram“. Честотата се отчита като част от всички случаи на ngrams с тази дължина, нормализирана по броя на книгите, публикувани през тази година (ngram/година/издадени книги). Фигурата е създадена с помощта на ngram viewer на Google (https://books.google.com/ngrams), който съдържа годишен брой ngrams, намерени в източници, отпечатани между 1500 и 2008 г. Мащаб отдясно: За задълбочено обучение числата представляват интерес за търсене в световен мащаб спрямо най-високата точка на графиката за дадената година за термина „дълбоко обучение“ (както е съобщено от https://trends.google.com/trends/). Скалата отдясно е изместена вертикално, за да съответства през 2004 г. на съответната (не е показана) честота на ngram за дълбоко обучение (скала отляво).

Backprop: Съкратено от „обратното разпространение на грешки“, той се използва широко за прилагане на градиентно-спускащо обучение към многослойни мрежи. Той използва правилото на веригата от смятане, за да изчисли итеративно градиента на функцията на разходите за всеки слой.

Изпъкналост: Функция с реална стойност се нарича „изпъкнала“, ако отсечката от която и да е от двете точки на графиката на функцията лежи върху или над графиката (Boyd & Vandenberghe, 2004). Проблемът е изпъкнал, ако неговата функция на разходите е изпъкнала. Изпъкналостта гарантира, че градиентното спускане винаги ще намери глобалния минимум.

Конволюционна невронна мрежа (ConvNet): Вкоренени в Neocognitron (Fukushima, 1980) и вдъхновени от простите и сложни клетки, описани от Hubel и Wiesel (1962), ConvNets прилага обратното обучение към многослойните невронни мрежи, базирани на конволюцията и обединяването (LeCun et al., 1989; LeCun, Bottou, Bengio, & Haffner, 1998).

Функция на разходите: Функция, която присвоява реално число, представляващо цена на кандидат-решение, като измерва разликата между решението и желаната продукция. Решаването чрез оптимизация означава минимизиране на разходите.

Кръстосана проверка: Оценява способността на мрежата да обобщава от данните, които е обучила, до нови данни.

Дълбоко обучение: Успешна и популярна версия на машинно обучение, която използва backprop невронни мрежи с множество скрити слоеве. Успехът през 2012 г. на AlexNet, тогава най-добрата мрежа за машинно обучение за разпознаване на обекти, беше повратната точка. Дълбокото обучение вече е повсеместно в Интернет. Идеята е всеки слой от обработка да извършва последователно по-сложни изчисления на данните, за да даде на пълната многослойна мрежа по-изразителна мощ. Недостатъкът е, че е много по-трудно да се обучат многослойни мрежи (Goodfellow et al., 2016).

Обобщение: Колко добре класификаторът се представя на нови, невиждани примери, които не е видял по време на обучение.

Градиентно спускане: Алгоритъм, който минимизира разходите чрез постепенно променяне на параметрите в посока на най-стръмно спускане на разходната функция.

Хебско обучение: Според правилото на Хеб, ефективността на синапса се увеличава след корелирана пре- и пост-синаптична активност. С други думи, невроните, които стрелят заедно, се свързват заедно (Lowel & Singer, 1992). Известен също като пластика, зависима от времето на скока (Caporale & Dan, 2008).

Машинно обучение: Всеки компютърен алгоритъм, който се научава как да изпълнява задача директно от примери, без човек да предоставя изрични инструкции или правила за това. В един тип машинно обучение, наречено „контролирано обучение“, се предоставят правилно етикетирани примери на алгоритъма за обучение, който след това се „обучава“ (т.е. параметрите му се коригират) да изпълнява задачата самостоятелно и да обобщава за невидими примери.

Невронни мрежи: Изчислителни системи, вдъхновени от биологични невронни мрежи, които се състоят от отделни неврони, изучаващи връзките им с други неврони, за да решават задачи, като разглеждат примери.

Учене под наблюдение: Всеки алгоритъм, който приема набор от етикетирани стимули - тренировъчен набор - и връща класификатор, който може да маркира стимули, подобни на тези в тренировъчния набор.

Поддържаща векторна машина (SVM): Тип алгоритъм за машинно обучение за класификация. SVM използва „трика на ядрото“, за да се научи бързо да извършва нелинейна класификация, като намира граница в многомерно пространство, която разделя различни класове и увеличава разстоянието на примерите на класове до границата (Cortes & Vapnik, 1995).

Учене без надзор: Открива структура и излишък в данни без етикети. Той се използва по-рядко от компютърните учени от контролираното обучение, но представлява голям интерес, тъй като етикетираните данни са оскъдни, докато немаркираните данни са в изобилие.

За разлика от популярното през 70-те и 80-те години ръчно изработено разпознаване на модели (включително сегментиране и групиране), алгоритмите за задълбочено обучение са общи, с малка специфичност за домейна. 1 Те заменят ръчно проектираните детектори на функции с филтри, които могат да бъдат научени от данните. Напредъкът в средата на 90-те години в машинното обучение го направи полезен за практическа класификация, като разпознаване на почерк (LeCun et al., 1989; Vapnik, 2013).

Машинното обучение позволява на неврофизиолог да декодира невронна активност, без да познава рецептивните полета (Seung & Sompolinsky, 1993; Hung. Kreiman, Poggio и DiCarlo, 2005). Машинното обучение е голяма стъпка в изместването на акцента в неврологията от това как клетките кодират към това, което кодират - тоест това, което този код ни казва за стимула (Barlow, 1953; Geisler, 1989). Картирането на рецептивно поле е основата на неврологията (започвайки с картирането на тактилни „сензорни кръгове“ от Вебер от 1834 г.). Това някога е изисквало едноклетъчен запис, като се търсят минути или часове как една клетка реагира на всеки от може би сто различни стимула. Днес е ясно, че характеризирането на рецептивното поле на един неврон, което е било безценно в ретината и V1, не успява да характеризира как по-високите зрителни области кодират стимула. Техниките за машинно обучение разкриват „как невроналните отговори могат да бъдат използвани най-добре (комбинирани) за информиране на вземането на възприемащи решения“ (Graf, Kohn, Jazayeri, & Movshon, 2011). Простотата на машинното декодиране може да бъде добродетел, тъй като ни позволява да открием какво може лесно да се прочете (например от един неврон надолу по веригата; Hung et al. 2005). Постигането на психофизични нива на ефективност при декодиране на идентичността и местоположението на стимулен обект от невронната реакция показва, че измерената невронна ефективност разполага с цялата информация, необходима на наблюдателя за изпълнение на задачата (Majaj, Hong, Solomon, & DiCarlo, 2015; Hong, Yamins, Majaj, & DiCarlo, 2016).

Дълбокото обучение, от друга страна, осигурява доста добър наблюдател, който се учи, което може да информира за изучаване на човешкото обучение. 2 По-специално, това може да разкрие ограниченията за обучение, наложени от набора от стимули, използвани в обучението. Освен това, за разлика от SDT, дълбоките невронни мрежи се справят със сложността на реалните задачи. Може да бъде трудно да се разбере дали поведенческата ефективност е ограничена от набора от стимули, тяхното невронно представяне или от процеса на вземане на решения от наблюдателя (Majaj et al., 2015). Последиците за изпълнението на класификацията не са очевидни от директната проверка на семействата стимули и техните нервни реакции. SDT определя оптимална производителност за класифициране на известни сигнали, но не ни казва как да обобщим отвъд учебния набор. Машинното обучение го прави.

Минуси: Чести оплаквания

Някои биолози посочват, че нервните мрежи не съвпадат с това, което знаем за невроните (напр. Crick, 1989; Rubinov, 2015; Heeger, 2017). Биологичните мозъци се учат на работа, докато невронните мрежи трябва да се сближат, преди да могат да бъдат използвани. Освен това, веднъж обучени, дълбоките мрежи обикновено изчисляват по обратен начин, докато в кората има големи повтарящи се вериги. Но това може просто да отразява различните начини, по които използваме изкуствени и реални неврони. Изкуствените мрежи са обучени за фиксирана задача, докато зрителният ни мозък трябва да се справи с променящата се среда и изискванията на задачите, така че никога не надраства нуждата от капацитет за учене. Освен това напоследък има голям напредък в използването на обучени повтарящи се невронни мрежи както за изчислителни задачи, така и като обяснения за невронни явления (Barak, 2017).

Не е ясно, като се има предвид това, което знаем за невроните и невронната пластичност, дали backprop мрежа може да бъде внедрена с помощта на биологично правдоподобни схеми (но виж Mazzoni, Andersen, & Jordan, 1991; Bengio, Le, Bornschein, Mesnard, & Lin, 2015 ). Съществуват обаче няколко обещаващи усилия за прилагане на по-правдоподобни правила за обучение, като например пластичност, зависима от времето на скока (Mazzoni et al., 1991; Bengio et al., 2015; Sacramento, Costa, Bengio, & Senn, 2017).

Инженерите и компютърните учени, макар и вдъхновени от биологията, се фокусират върху разработването на инструменти за машинно обучение, които решават практически проблеми. По този начин моделите, базирани на тези инструменти, често не включват известни ограничения, наложени от физиологията. На това може да се противопостави, че всеки биологичен модел е абстракция и може да бъде полезен, дори ако не успява да улови всички детайли на живия организъм.

Някои биологични моделисти се оплакват, че невронните мрежи имат тревожно много параметри. Дълбоките невронни мрежи продължават да бъдат непрозрачни. Преди моделирането на невронни мрежи, един модел беше по-прост от данните, които обясняваше. Дълбоките невронни мрежи обикновено са толкова сложни, колкото данните и решенията са трудни за визуализиране (но вижте Zeiler & Fergus, 2013). Докато учебните набори и усвоените тегла са дълги списъци, генеративните правила за мрежата (компютърните програми) са кратки. Един вкус на това са предложенията за каскадни канонични изчисления в кората (Hubel & Wiesel, 1962; Simoncelli & Heeger, 1998; Riesenhuber & Poggio, 1999; Serre, Wolf, Bileschi, Riesenhuber и Poggio, 2007). Традиционно наличието на много параметри често е довело до пренастройване - тоест, добро представяне на тренировъчния набор и лошо представяне извън него - но пробивът е, че мрежите за дълбоко обучение с огромен брой параметри въпреки това се обобщават добре. Освен това, байесовите непараметрични модели предлагат дисциплиниран подход към моделирането с неограничен брой параметри (Gershman & Blei, 2011). Mallat (2016) също отбелязва, че известните симетрии на проблема могат значително да намалят броя на параметрите, които трябва да се научат.

Някои статистици се притесняват, че строгите статистически инструменти се изместват от дълбокото обучение, което няма строгост (Friedman, 1998; Matloff, 2014; но виж Breiman, 2001; Efron & Hastie, 2016). Рядко се изказват предположения. Няма доверителни интервали за решението. Изпълнението обаче обикновено е кръстосано валидирано, показващо обобщение. Дълбокото учене не е изпъкнало, но е доказано, че изпъкналите мрежи могат да изчислят задната вероятност (напр. Rojas, 1996). Освен това, машинното обучение и статистиката изглежда се сближават, за да предоставят по-обща перспектива за строго вероятностно заключение (Chung, Lee и Sompolinsky, 2018).

Някои физиолози отбелязват, че декодирането на нервната активност за възстановяване на стимула е интересно и полезно, но не успява да обясни какво правят невроните. Някои визуални психофизици отбелязват някои съществени разлики между представянето на човешките наблюдатели и дълбоките мрежи по задачи като разпознаване на обекти и изкривяване на изображението (Ullman, Assif, Fetava и Harari, 2016; Berardino, Laparra, Ballé и Simoncelli, 2017). Някои когнитивни психолози отхвърлят дълбоките невронни мрежи като неспособни да „овладеят някои от основните неща, които децата правят, като да научат миналото време на редовен глагол“ (Marcus et al., 1992). Дълбокото обучение е бавно. За да разпознава обекти в естествени изображения с точност на разпознаване на възрастен, съвременната дълбока невронна мрежа се нуждае от 5000 етикетирани примера за категория (Goodfellow, Bengio и Courville, 2016). Но децата и възрастните се нуждаят само от 100 етикетирани букви от непозната азбука, за да достигнат същата точност като свободно владеещите читатели (Pelli et al., 2006). Преодоляването на тези предизвикателства може да изисква повече от задълбочено обучение.

Тези настоящи ограничения карат практикуващите да подобрят обхвата и строгостта на дълбокото обучение. Но имайте предвид, че някои от най-добрите класификатори в компютърните науки са вдъхновени от биологични принципи (Rosenblatt, 1958; LeCun, 1985; Rumelhart, Hinton, & Williams, 1986; LeCun et al., 1989; Riesenhuber & Poggio, 1999; и виж LeCun, Bengio и Hinton 2015). Сега някои от тези класификатори са толкова добри, че понякога надвишават човешките показатели и могат да служат като груби модели за класифициране на биологичните системи (напр. Khaligh-Razavi & Kriegeskorte, 2014; Yamins et al., 2014; Ziskind et al., 2014; Testolin et al., 2017).

Основни етапи в класификацията

Математика срещу инженерство

Историята на машинното обучение има две нишки: математика и инженерство (Фигура 2). В математическата нишка двама статистици, Fisher (1922) и по-късно Vapnik (2013), разработиха математически трансформации за разплитане на категории. Те приеха разпределения и доказаха конвергенция.

- Deep Docking Платформа за дълбоко обучение за увеличаване на структурно базираното откриване на лекарства

- GitHub - машинно обучение с отслабване с тегло, отговаря на кетозата как ефективно да отслабнете

- Можете ли да загубите мазнини по корема с помощта на елипсовидна машина Fitnessenger

- Електроактивни въглеродни наноформи сравнително проучване чрез последователно арилиране и клик химия

- Предимства на елиптичната машина срещу бягаща пътека